Вся правда об эхо-комнатах и о том, как работает алгоритм Twitter, выбирая, что же нам читать.

Ленту Twitter жедневно пролистывает больше 150 миллионов активных пользователей, и по уверениям соцсети, именно алгоритм, формирующий персонализированную ленту, помогает привлечь и удержать не платформе миллионы новых людей. При этом мы всё ещё довольно мало знаем о нюансах его работы: что он повышает в выдаче? До какой степени? И каковы возможные последствия?

Сам Twitter говорит, что использует систему глубокого обучения под внутренним названием DeepBird, чтобы определить, какие твиты будут интересны пользователю. Без особых нюансов и подробностей. Но что скрывается за этим «чёрным ящиком»? Эксперты протестировали его с помощью аккаунтов-марионеток.

Новое исследование, проведённое Computational Journalism Lab, выявило, что алгоритмическая лента Twitter:

- 1. Содержит меньше твитов с внешними ссылками

- 2. Увеличивает количество рекомендуемых твитов (из неподписанных аккаунтов)

- 3. Предлагает большее разнообразие источников

- 4. Немного изменяет выдачу постов в рамках одной тематики

- 5. Создаёт небольшой эффект эхо-камеры

- Итак, каковы же возможные последствия такой персонализации?

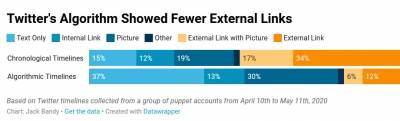

1. Содержит меньше твитов с внешними ссылками

Оказалось, что алгоритм Twitter значительно понижает охваты постов с ссылками на внешние источники. Если в хронологической ленте в среднем 51% твитов имеют внешнюю ссылку, то в алгоритмической — 18%. При этом выдача внутренних ссылок Twitter выростает с 12% до 13%, а внутренних изображений — с 19% до 30%.

2. Увеличивает количество рекомендуемых твитов (из неподписанных аккаунтов)

В среднем предлагаемые твиты (из неподписанных аккаунтов) составляют 55% алгоритмической ленты. При этом ленты аккаунтов-марионеток изучали дважды в день и анализировали только первые 50 твитов. Возможно, если анализировать первые 200, а не 50 постов, соотношение будет несколько иным.

3. Предлагает большее разнообразие источников

В среднем алгоритм почти удваивает количество уникальных учётных записей в ленте — с 663 до 1169. Алгоритм соцсети также несколько понижает выдачу постов от аккаунтов, которые часто твитят: в среднем на десять аккаунтов с наибольшим количеством твитов приходилось 52% твитов в хронологической ленте, и только 24% — в алгоритмической. К тому же более низкий Gini-коэффициент для алгоритмических лент (0,59 против 0,72) указывает на большее неравенство именно в хронологических лентах.

Таким образом алгоритм не создаёт эффект полноценного информационного пузыря, который многие приписывают соцсетям.

Читать также: Как обходить правила модерации соцсетей. Часть 1: тайная сделка Facebook и Google, информационные пузыри и вовлечение

Эти данные как раз доказывают, что алгоритм Twitter диверсифицирует персонализированную ленту за счёт учётных записей, которые не отображаются в хронологической ленте, а также контролирует аккаунты, которые доминировали бы в хронологической. Таким образом алгоритмическая лента несколько шире и беспристрастнее хронологической.

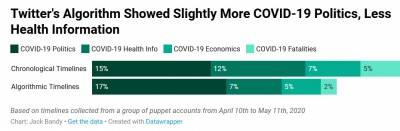

4. Немного изменяет выдачу постов в рамках одной тематики

Эффект выявился при анализе четырёх групп твитов, связанных с пандемией COVID-19, — с уклоном в политику (например, описание реакции президента на пандемию), с информацией о здоровье (например, о факторах риска), с новостями экономики (например, о ВВП или потере работы) и о жертвах болезни (например, отчёты о смертельных случаях). В целом алгоритм Twitter сократил выдачу твитов в каждой из групп, кроме политики:

Таким образом алгоритмы социальных сетей могут иногда снижать доступ к важной информации (например, информации о здоровье и смертности в связи с COVID-19), одновременно приоритезируя другие темы.

Тем не менее, эффект представлял собой не герметичный информационный пузырь, а скорее эхо-камеру, в которой одни темы поднимались чаще, а другие — заглушались. Как в анализе партий — в следующем пункте.

5. Создаёт небольшой эффект эхо-камеры

При анализе партийных предпочтений, эксперты измерили, как алгоритм Twitter меняет охваты аккаунтов с разными политическими взглядами. Это не было проверкой на «политическую предвзятость» алгоритма, скорее — на то, как алгоритм влияет на охваты сторонних аккаунтов по сравнению с хронологической лентой.

Результаты отчасти перекликаются с данными исследования Facebook от 2015 года, которое показало, что основная «предвзятость» алгоритма определяется выбором самого пользователя (за счёт собранных данных — за кем он следит и на что кликает). Тем не менее, небольшой эффект эхо-камеры всё-таки наблюдается.

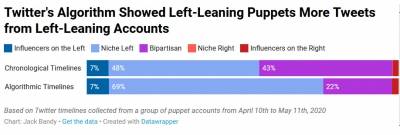

Например, алгоритмическая лента понижает охват аккаунтов, которые классифицировала как двухпартийные. Так, у марионеток с левым уклоном хронологическая лента содержала 43% твитов двухпартийных аккаунтов (фиолетовый цвет на диаграмме ниже), а алгоритмическая — не больше 22%:

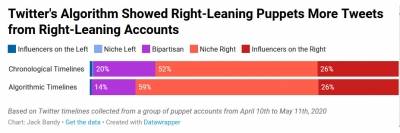

Схожий эффект наблюдался и у марионеток с правым уклоном: их хронологические ленты на 20% состояли из твитов двухпартийных аккаунтов, а алгоритмические — только на 14%:

Эффект эхо-камеры трудно измерить, поэтому, если вы хотите узнать больше, ознакомьтесь с техническими деталями или полным текстом исследования.

Примечательно, что, например, Барака Обаму и Fox News Twitter тоже счёл «двухпартийными» — потому что за их постами обычно следили как правые, так и левые.

Итак, каковы же возможные последствия такой персонализации?

Например, уменьшение количества внешних ссылок может серьёзно повлиять на новостную экосистему. Согласно опросу Pew 2018 года, около семи из десяти взрослых пользователей Twitter в США используют соцсеть для чтения новостей. Поскольку алгоритм Twitter сокращает доступ к внешним новостным ссылкам, у пользователей меньше шансов прочитать высококачественные СМИ, а у новостных агентств — снижается веб-трафик, а значит — и доходы от рекламы.

В то же время нужно чётко понимать, что алгоритм — это не очередная страшилка, а просто часть большой и сложной медиа-экосистемы.

Мы, конечно, можем настроить алгоритм(ы), но должны также рассматривать и другие возможности для улучшения обмена новостями и информацией в интернете. Например, повышать медиаграмотность, совершенствовать пользовательские интерфейсы, структуры управления и нормативные меры — всё это улучшит экосистему, наряду с потенциальными настройками алгоритма.

Как недавно написали Энн Эпплбаум и Пётр Померанцев, «интернет не обязательно должен быть ужасным».

Источник: www.cossa.ru